Vers un contrat social urbain-numérique : conclusions d'un sprint de recherche sur les espaces numériques sécurisés

Laura Garcia Vargas

La sécurité en ligne est souvent considérée comme un problème technique à résoudre à l'aide d'outils plus performants, de lois plus strictes ou d'algorithmes plus intelligents. Mais que se passe-t-il si la sécurité ne peut pas être conçue de manière technique ? Que se passe-t-il si elle doit être négociée collectivement dans les espaces numériques et physiques que nous occupons ?

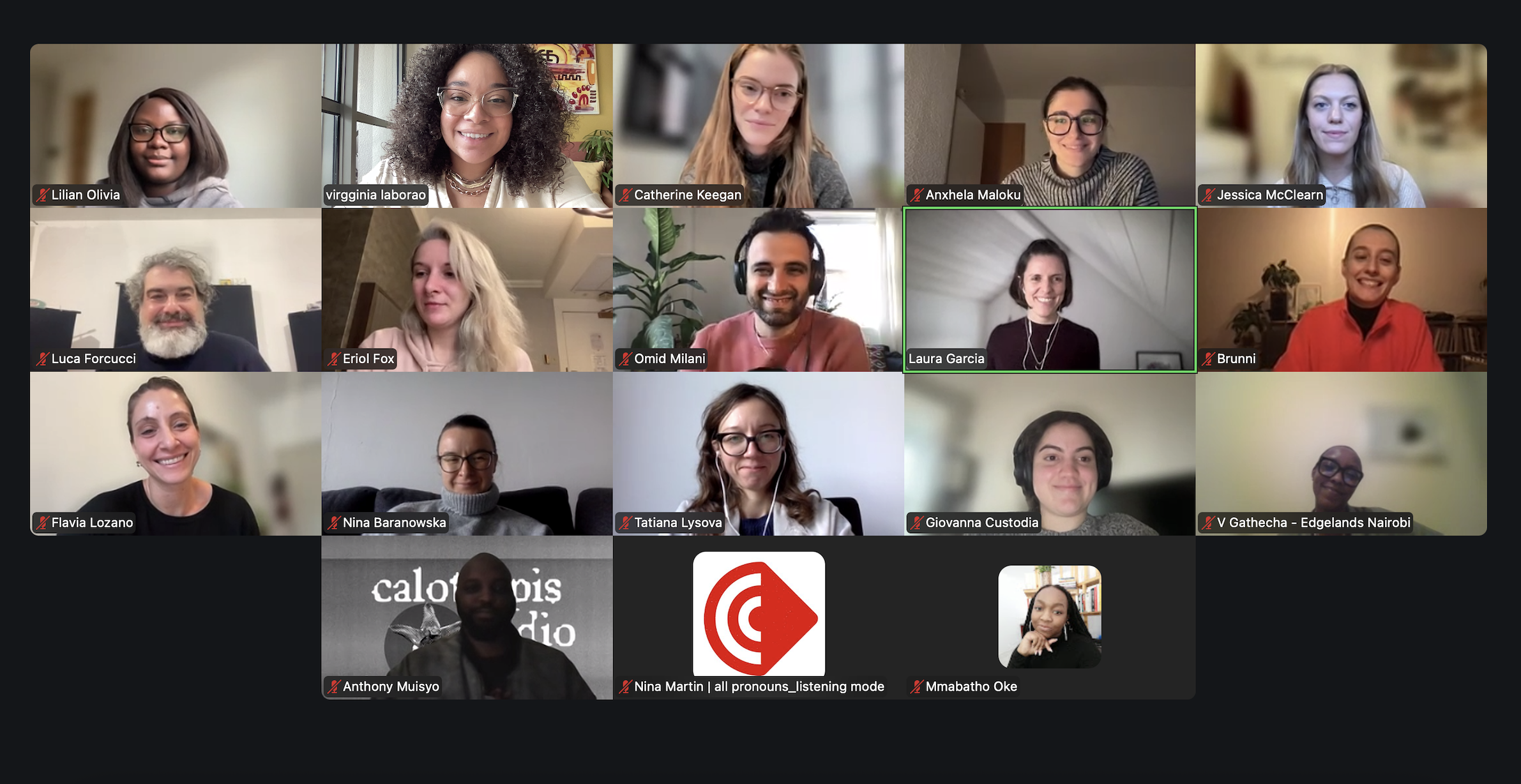

Il y a huit semaines, nous avons lancé un sprint de recherche afin d'étudier comment les communautés créent, habitent et protègent les espaces en ligne. Ce sprint a réuni des universitaires, des designers, des technologues, des artistes et des militants du monde entier afin de repenser le contrat social urbain à l'ère numérique.

Au cours du sprint, nous avons eu le plaisir de discuter avec six experts inspirants — Eriol Fox, Anxhela Maloku, Suzie Dunn, Qingyi Ren, Cade Diehm et Caroline Sinders — dont l'expérience et les connaissances ont guidé notre réflexion collective.

Une idée centrale qui ressort de ces conversations est que la sûreté et la sécurité sont relationnelles et contextuelles. Il ne s'agit pas d'états fixes ou d'objectifs techniques, mais plutôt de résultats façonnés par les interactions, la confiance, les environnements et les normes communes.

En nous concentrant sur les communautés plutôt que sur les individus lorsque nous discutons des espaces sécurisés, nous avons été amenés à poser des questions plus profondes, axées sur les valeurs : qui définit ce qu'est une communauté ? Quels sont les besoins prioritaires ? Quelles expériences influencent les décisions en matière de conception ? Qui est écouté et qui est systématiquement exclu ?

Un concept clé qui est ressorti de ces questions était la confiance. Non seulement la confiance dans une plateforme particulière, mais aussi la confiance que les membres de la communauté cultivent (ou s'efforcent de cultiver) à travers leur participation à un espace en ligne.

Dans ce contexte, la confiance n'est pas seulement un mot à la mode à ajouter à la fin d'un projet. Elle exige que les communautés soient impliquées dès le début et aient la possibilité de s'exprimer de manière créative. Elles doivent également disposer de l'espace nécessaire pour façonner les outils qui auront une incidence sur leur vie. Après tout, les outils développés par et pour une communauté particulière sont beaucoup plus susceptibles de refléter son identité, sa culture et ses valeurs.

Cela est particulièrement important pour les communautés qui sont exposées à un risque plus élevé. Pour ces communautés, les fonctionnalités de confidentialité et de sécurité ne sont pas seulement des commodités, elles sont vitales. Ce que certaines personnes considèrent comme facultatif peut être une question de survie pour d'autres. Cela a renforcé une idée récurrente du Sprint : une bonne conception donne la priorité à la sécurité des plus vulnérables, car lorsqu'ils se sentent en sécurité, c'est toute la communauté qui en bénéficie.

La notion de confiance a également été au cœur des discussions sur la représentation des personnes queer, la permanence numérique et la fluidité de l'identité. Ces conversations nous ont rappelé que la confiance est également essentielle pour une conception inclusive, qui doit s'adapter à l'évolution des définitions de soi plutôt que d'enfermer les personnes dans des catégories statiques ou des profils rigides.

En ancrant notre discussion dans les communautés, nous avons également découvert une réalité simple mais souvent négligée : les domaines numérique et physique sont inextricablement liés.

Au cours des quatre dernières années, chez Edgelands, nous avons exploré comment la numérisation croissante de la sécurité modifie notre *contrat social urbain*, c'est-à-dire l'ensemble évolutif de règles et d'attentes qui façonnent la manière dont les gens vivent, se déplacent et interagissent dans les espaces urbains. Les discussions menées pendant le Sprint m'ont fait prendre conscience que ce dont nous négocions réellement, c'est un contrat social urbain-numérique : un ensemble évolutif de règles et d'attentes qui façonnent non seulement notre façon de vivre ensemble dans les espaces urbains physiques, mais aussi dans les espaces numériques et dans le domaine hybride qui les relie (que les intervenants ont qualifié de «para-réel »).

Ces sphères sont désormais si étroitement liées que tenter de les séparer semble artificiel et occulte souvent les dynamiques les plus importantes. Les conditions qui rendent possibles les espaces sécurisés en ligne sont ancrées dans les structures culturelles et sociales du monde physique, et les préjudices subis par les personnes en ligne se répercutent dans leur vie quotidienne.

Une sécurité efficace dépend donc de multiples éléments interdépendants et ne peut être confiée à l'un d'entre eux seul : ni à la loi, ni au code, ni à la conception, ni à la responsabilité individuelle.

La reconnaissance de cette complexité révèle un schéma récurrent : de profondes disparités structurelles.

Écarts entre les codeurs et les utilisateurs. Écarts entre les spécialistes en sciences sociales et les technologues. Écarts entre la conception axée sur le profit et les besoins de la communauté.

Ces lacunes sont source de tensions réelles dans la manière dont la sécurité est conçue et mise en pratique.

Par exemple, même lorsque les plateformes adoptent des paramètres de confidentialité par défaut ou proposent des paramètres plus accessibles, l'efficacité de ces mesures de sécurité dépend toujours de la capacité des utilisateurs à les comprendre et à les utiliser. Trop souvent, ces outils sont présentés dans un langage opaque et hautement technique. Dans ce cas, même les conceptions bien intentionnées échouent : les utilisateurs se sentent dépassés, les programmeurs se sentent incompris et les décisions cruciales sont obscurcies par le jargon.

Ici, l'empathie a été identifiée comme essentielle. Adopter une approche empathique de la conception, depuis les premières étapes conceptuelles jusqu'à l'interface finale, permet de combler le fossé entre ce que supposent les codeurs et ce dont les utilisateurs ont réellement besoin. Cette approche transforme la sécurité d'une fonctionnalité technique en quelque chose qui peut être compris, maîtrisé et qui inspire confiance.

Cependant, le design seul ne peut pas tout assumer. Le Sprint a clairement démontré que même les outils les plus soigneusement conçus dépendent de fondements culturels, sociaux et politiques qui peuvent soit renforcer, soit affaiblir leur impact.

Bien que les lois et les réglementations aient leur place, on nous a rappelé que les outils juridiques doivent être utilisés en dernier recours, réservés aux préjudices les plus graves. La sécurité au quotidien dépend bien plus des stratégies culturelles, éducatives et axées sur la conception que des interdictions punitives, qui s'attaquent rarement aux causes profondes des problèmes. Une approche réparatrice et centrée sur l'humain, qui encourage le dialogue plutôt que le recours à la punition, renforce la confiance et consolide les communautés.

L'accent mis sur les approches réparatrices ne doit pas être confondu avec un appel à l'inaction. L'absence de réglementation crée sa propre forme d'instabilité, fragmentant les communautés, favorisant la désinformation et exposant les personnes vulnérables à des risques accrus. L'inaction n'est donc jamais neutre, car elle a des conséquences réelles tant dans l'espace numérique que physique.

L'indissociabilité de nos mondes numérique et physique est également apparue clairement dans notre discussion sur ce qui se passe lorsque l'environnement numérique lui-même devient instable. Dans les situations où la connectivité est intentionnellement coupée ou involontairement perdue, certaines plateformes doivent conserver des fonctionnalités essentielles, telles que les alertes de sécurité, les contacts d'urgence et les points de rencontre. Les manifestants et les groupes à risque ne peuvent pas se permettre de perdre l'accès à ces outils dès que les réseaux tombent en panne. La résilience doit être intentionnellement conçue, et non supposée.

Dans le même temps, l'infrastructure mondiale qui soutient nos vies numériques est à la fois inégale et fragile. ****Le travail acharné des modérateurs et des utilisateurs passe souvent inaperçu, et les systèmes physiques qui sous-tendent les plateformes numériques sont vulnérables aux catastrophes naturelles, aux ingérences politiques et au manque de supervision humaine, une situation exacerbée par les réductions d'effectifs opérées par les entreprises. Et pourtant, ces vulnérabilités sont rarement reconnues dans les discours sur l'expansion numérique sans fin.

Alors que nous repensons notre contrat social urbain-numérique, une chose apparaît clairement : toute solution durable et axée sur la communauté doit évoluer de manière fluide entre le physique et le numérique. Les deux ne peuvent et ne doivent pas être séparés.

La modération en est un exemple flagrant. Bien qu'elle soit essentielle à la création d'environnements numériques sûrs, elle ne peut être réduite à des systèmes automatisés ou externalisée à des travailleurs sous-payés sans soutien culturel, linguistique ou émotionnel adéquat. Une modération efficace est plus efficace lorsqu'elle est menée par des membres de la communauté qui comprennent les contextes locaux et lorsque les gens ont accès à un soutien humain réel. Les services d'assistance régionaux, les lignes d'assistance téléphonique adaptées à la culture locale et les personnes qui sont déjà confrontées à la violence au sein de leur propre communauté se sont révélés être des approches prometteuses, à condition que nous protégions et soutenions également ces travailleurs de première ligne.

De même, si les pratiques de cybersécurité sont essentielles pour protéger les plateformes contre les menaces externes, elles ne peuvent à elles seules garantir la sécurité. Elles doivent être associées à des mécanismes centrés sur l'humain. L'une de ces approches consiste à faire appel à des « personnes de confiance désignées » : des individus désignés au sein d'une communauté ou d'une institution qui peuvent aider directement les utilisateurs et servir d'intermédiaires entre les personnes, la technologie et les structures de gouvernance. Ces rôles permettent de garantir que les commentaires sur les questions de sécurité sont pris en compte et donnent lieu à des mesures concrètes.

Dans l'ensemble, ces observations indiquent un contrat social urbain-numérique ancré dans les valeurs communautaires et une conception axée sur l'empathie, établissant un équilibre prudent entre les garanties technologiques et les relations humaines. J'espère que cette vision d'un avenir numérique plus sûr continuera d'évoluer grâce à la recherche continue, à la collaboration et au partage des responsabilités. Après tout, dans un monde où les vies numériques et physiques sont indissociables, la création d'espaces plus sûrs n'est plus une option . Il s'agit d'une responsabilité collective et d'une négociation permanente.

Si la sécurité est quelque chose que nous construisons ensemble plutôt que quelque chose qui peut être imposé d'en haut, alors les communautés ont besoin de plus que de simples principes : elles ont également besoin d'outils. À cette fin, les chercheurs de Sprint ont développé une boîte à outils inspirée de leur expérience vécue et conçue pour aider les communautés en ligne à créer, réfléchir et maintenir des espaces plus sûrs selon leurs propres conditions.

Le kit d'outils devrait être publié début 2026, et j'encourage les lecteurs à guetter sa sortie, qui s'inscrira dans la continuité des discussions issues du Sprint.

Je tiens à remercier sincèrement tous les intervenants qui ont aimablement partagé leurs connaissances et leur expérience, ainsi que tous les participants au Research Sprint, pour leur temps, leur énergie et leurs contributions réfléchies au cours des huit dernières semaines.

Rencontrez les intervenants

Eriol Fox

Eriol travaille comme designer depuis plus de 15 ans, d'abord dans des entreprises à but lucratif, puis dans des ONG et des organisations de logiciels libres, où il s'est occupé de problèmes complexes tels que les systèmes alimentaires durables, la consolidation de la paix et les technologies de réponse aux crises. Eriol travaille aujourd'hui chez Superbloom sur des projets de conception, de recherche, de logiciels libres et de technologie.

Ils font également partie des équipes principales du groupe de travail Open Source Design et Human Rights Centred Design, ainsi que du groupe de travail Sustain UX & Design, et contribuent à l'animation d'un podcast sur l'open source et le design.

Eriol est une personne queer non binaire qui utilise les pronoms « ils/elles ».

Anxhela Maloku

Un concepteur UX motivé par la complexité qui se cache derrière ce qui semble simple, par la manière dont les systèmes et les récits façonnent l'expérience technologique des utilisateurs. Mon travail explore comment le design peut rendre la complexité technique plus humaine et transparente.

Auteur de recherches publiées sur les modèles UX préservant la confidentialité, dont le principal artefact est un catalogue de modèles de confidentialité UI/UX destiné à aider les concepteurs à intégrer ces modèles dans les interfaces quotidiennes.

.jpg)

Suzie Dunn

Suzie Dunn est directrice du Law and Technology Institute et professeure adjointe à la Schulich School of Law de l'Université Dalhousie. Ses recherches portent sur les intersections entre l'égalité, la technologie et le droit, avec un accent particulier sur la violence sexiste facilitée par la technologie, l'intelligence artificielle et les deepfakes. Elle est partenaire de recherche dans le cadre d'un projet financé par le CRSH sur les expériences des jeunes en matière de violence sexuelle en ligne, intitulé « DIY Digital Safety ». Elle est également chercheuse principale au CIGI, où elle a dirigé la première phase du projet « Supporting Safer Digital Spaces » (Soutenir des espaces numériques plus sûrs), et membre du comité sur la violencefacilitée par la technologie du Fonds d'action et d'éducation juridiques pour les femmes de l' .

Qingyi Ren

Qingyi Ren 任晴宜 est un artiste numérique non binaire et chercheur en sciences, technologie et société (STS) au Critical Media Lab Basel, dont le travail explore l'intersection entre l'art, la technologie et la justice sociale. Passionné(e) par la compréhension des complexités de la théorie du genre, de l'éthique de l'IA et de l'identité numérique, il/elle est actuellement basé(e) à Bâle et consacre sa pratique artistique à dévoiler les préjugés subtils inhérents au domaine de l'apprentissage automatique et leur impact profond sur les identités marginalisées. À travers son art qui suscite la réflexion, il/elle remet en question le statu quo et inspire des conversations critiques autour de l'éthique de l'intelligence artificielle.

Cade Diehm

Cade est le fondateur de The New Design Congress, un organisme de recherche international qui vise à mieux comprendre le rôle de la technologie en tant que catalyseur social, politique et environnemental. Il étudie, écrit, conseille et intervient régulièrement sur des sujets tels que les structures du pouvoir numérique, la confidentialité, la guerre de l'information, la résilience, les économies Internet et la numérisation des villes.

Caroline Sinders

Caroline Sinders est chercheuse et artiste spécialisée dans la conception d'apprentissage automatique. Depuis plusieurs années, elle étudie les intersections entre l'impact de la technologie sur la société, la conception d'interfaces, l'intelligence artificielle, les abus et la politique dans les espaces numériques et conversationnels. Caroline Sinders est la fondatrice de Convocation Design + Research, une agence qui se concentre sur les intersections entre l'apprentissage automatique, la recherche sur les utilisateurs, la conception pour le bien public et la résolution de problèmes de communication complexes. En tant que designer et chercheuse, elle a travaillé avec Amnesty International, Intel, IBM Watson, la Wikimedia Foundation et d'autres organisations.