Redéfinir le contrat social urbain : les attentes de la génération Z en matière d'intégrité numérique

Sophie ZermattenÀ une époque où les interactions numériques façonnent presque tous les aspects de la vie, comment redéfinir le contrat social entre les citoyens, les gouvernements et les entreprises ?

À une époque où les interactions numériques façonnent presque tous les aspects de la vie, comment pouvons-nous redéfinir le contrat social entre les citoyens, les gouvernements et les entreprises ? Cette question était au cœur de notre cinquième dialogue numérique interurbain, au cours duquel des participants de différentes villes d'Edgelands ont exploré la manière dont la génération Z navigue dans le monde hyperconnecté d'aujourd'hui et ce qu'elle attend des systèmes qui le gouvernent.

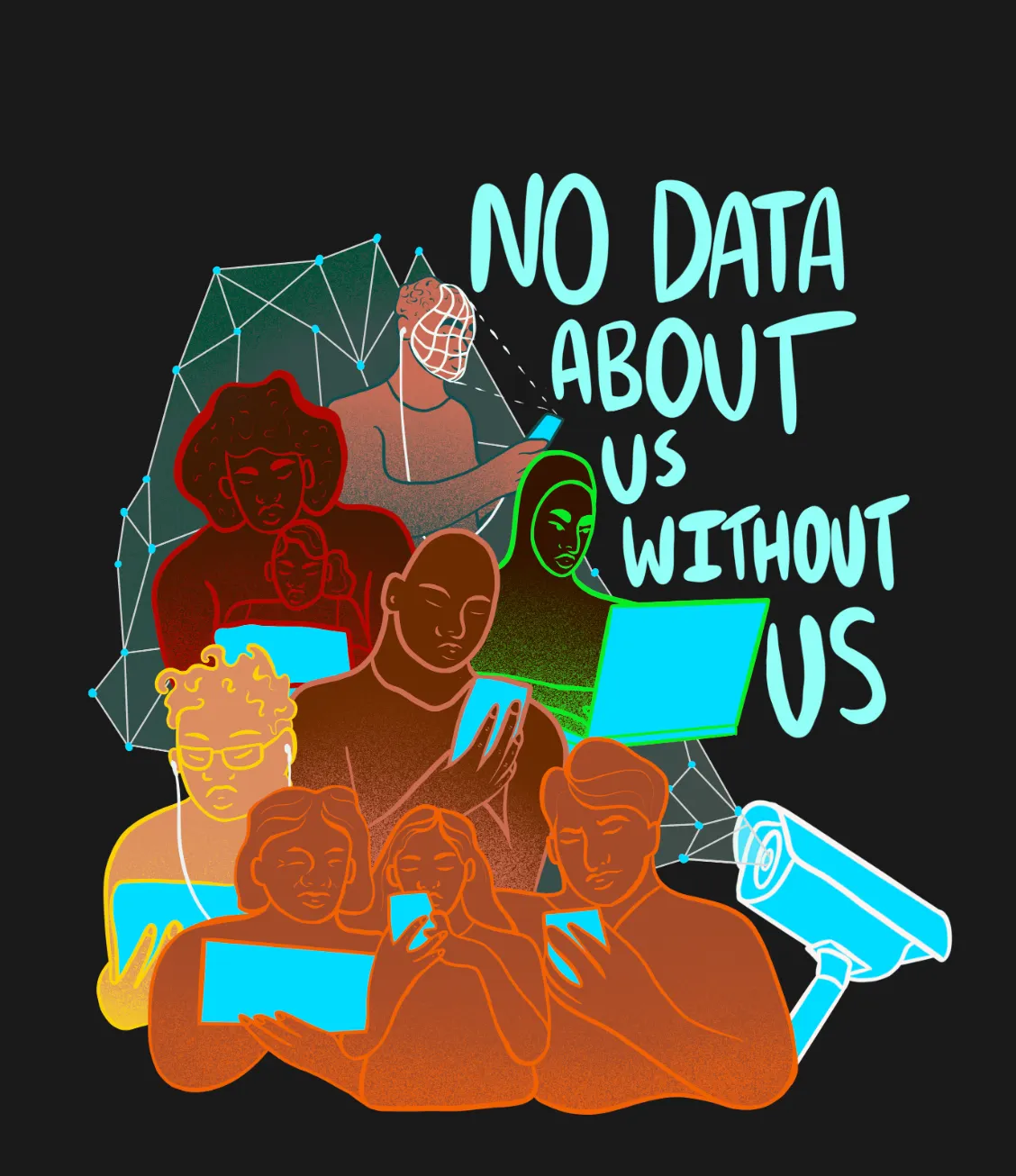

Au cours de cette conversation, des thèmes clés ont émergé autour de choix, contrôle, censure et surveillance, soulignant une profonde préoccupation pour l'intégrité numérique, mais aussi un désir de réimaginer la dynamique du pouvoir dans le paysage numérique.

Vivre sous surveillance : Un faux sentiment de sécurité ?

Les participants ont fait part de leur expérience personnelle de la surveillance dans la vie quotidienne, de la reconnaissance faciale dans les aéroports au suivi comportemental piloté par l'IA dans les supermarchés, en passant par les applications d'assurance maladie qui suivent les habitudes quotidiennes telles que l'activité physique et le régime alimentaire. Ces technologies promettent efficacité et sécurité, mais de nombreux participants ont exprimé leur malaise face aux compromis, en particulier lorsque la collecte de données devient de plus en plus intrusive.

Les dimensions géopolitiques de la surveillance, notamment en ce qui concerne les géants des médias sociaux comme TikTok, ont constitué une préoccupation notable. Si la plupart des grandes entreprises technologiques ont des pratiques similaires en matière de collecte de données, certaines plateformes sont plus surveillées que d'autres, souvent en raison de tensions politiques plutôt que de véritables préoccupations en matière de protection de la vie privée.

Au-delà de la collecte de données et des préoccupations géopolitiques, la surveillance joue également un rôle dans la mise en place de la censure. Il a été souligné que la surveillance accrue des espaces numériques, souvent déguisée en besoin de créer des espaces plus sûrs, soulève des questions importantes sur la liberté d'expression et la propagation de la désinformation.

Malgré ces inquiétudes, les participants ont reconnu un paradoxe troublant : eux et leurs pairs continuent d'utiliser et de dépendre de plateformes qu'ils savent abusives, et ils continuent d'accepter des politiques envahissantes sans poser de questions, en signant des conditions générales qu'ils n'ont pas lues. Cette conformité silencieuse, ont-ils tous convenu, est devenue une règle tacite de l'engagement numérique.

L'épée à double tranchant des plateformes numériques et de la gouvernance numérique

Les plateformes numériques et les outils d'IA présentent à la fois des opportunités et des risques, et cette tension était évidente dans les exemples mondiaux évoqués au cours de la discussion.

Au Kenya, par exemple, des militants ont utilisé des outils alimentés par l'IA pour traduire des projets de loi complexes, rendant ainsi les informations accessibles et contribuant à lutter contre la désinformation de la part des fonctionnaires. L'IA a également permis de répertorier les affaires de corruption, de mettre au jour les fautes commises et d'obliger les dirigeants à rendre compte de leurs actes.

De même, les plateformes de médias sociaux ont facilité l'organisation de la base et la mobilisation du public contre les politiques gouvernementales. Cependant, ces mêmes technologies ont été utilisées à des fins répressives : elles ont été déployées pour traquer et intimider les dissidents politiques, et des rapports font état d'enlèvements ou de disparitions d'individus après des mesures de répression du gouvernement.

Ces cas illustrent un paradoxe central : l'IA et les plateformes de médias sociaux peuvent renforcer la démocratie, mais aussi le contrôle autoritaire.

Les participants ont également réfléchi à la culture de la surveillance qui se développe dans les espaces universitaires et professionnels. Les systèmes basés sur le cloud soulèvent des questions sur la manière dont les universités, les employeurs et les gouvernements accèdent aux données stockées et les utilisent. Certains ont souligné que les chercheurs qui étudient des sujets sensibles sont confrontés à des vulnérabilités uniques, car ils ne bénéficient pas des mêmes protections que les journalistes.

Bien qu'il existe des solutions de remplacement à code source ouvert offrant de meilleures pratiques en matière de confidentialité et de sécurité, elles restent difficiles à adopter et à intégrer à grande échelle, laissant de nombreux utilisateurs piégés dans des environnements numériques auxquels ils ne font pas confiance, mais qu'ils ne peuvent fuir.

Repenser le pouvoir numérique

Tout au long de la conversation, un thème s'est dégagé : la nécessité de repenser les détenteurs du pouvoir dans les espaces numériques. Les participants ont réclamé davantage d'espaces publics sûrs, des conversations ouvertes, des réglementations plus strictes et des infrastructures numériques alternatives pour faire face aux préoccupations croissantes concernant les excès des entreprises, la surveillance et l'érosion de l'autonomie numérique.

Voici quelques propositions qui ont été faites :

- Il devrait y avoir davantage de logiciels libres disponibles et d'alternatives financées par des fonds publics afin de réduire la dépendance à l'égard des plateformes contrôlées par les entreprises.

- Les gouvernements doivent créer des politiques cohérentes et à long terme sur la confidentialité des données et des cadres éthiques pour l'IA qui ne fluctuent pas en fonction du leadership politique.

- L'IA et les espaces numériques doivent être pilotés par la communauté et répondre aux besoins du public.

- Le pouvoir de façonner les espaces numériques devrait être décentralisé. Les citoyens devraient avoir davantage de contrôle sur leurs interactions numériques, que ce soit par le biais de droits accrus en matière de confidentialité des données, de l'accès à des plateformes non commerciales ou de la possibilité de contester des algorithmes opaques.

- Les utilisateurs doivent avoir un accès plus clair aux informations sur la manière dont leurs données sont collectées et utilisées. Les plateformes devraient fournir des descriptions simplifiées et accessibles des termes clés.

- L'éducation à la culture numérique devrait être intégrée dans les programmes scolaires, afin d'équiper les jeunes pour qu'ils puissent naviguer de manière critique dans ces systèmes.

La discussion a mis en évidence une préoccupation collective : sans intervention significative, les espaces numériques continueront d'être façonnés par ceux qui en tirent profit, plutôt que par ceux qui y vivent. La reconquête de l'autonomie numérique passe par une prise de conscience du public, des changements de politique et une refonte fondamentale du contrat social numérique.