Transformer la police prédictive

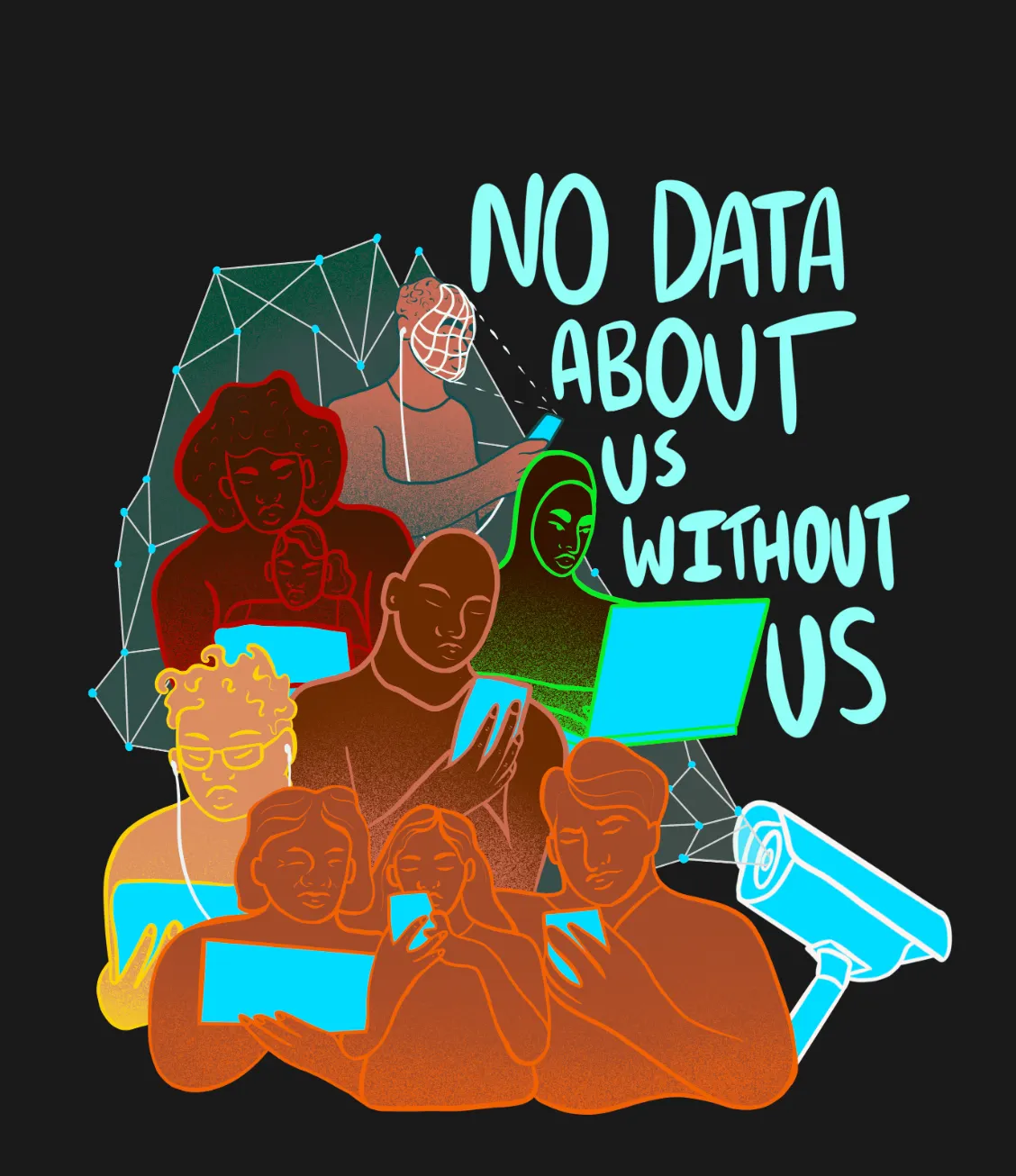

L'utilisation des réseaux sociaux en ligne pour identifier les suspects et les criminels potentiels s'inscrit dans le cadre d'une tendance des forces de l'ordre à la surveillance des données massives (big data) et à l'analyse prédictive de la police. Cependant, les critiques mettent en garde contre le fait que l'utilisation de la police prédictive peut renforcer la discrimination raciale dans le système de justice pénale.

En réponse au meurtre brutal de George Floyd par la police de Minneapolis en mai 2020, des manifestations "Black Lives Matter" ont éclaté dans tout le pays. Grâce aux médias sociaux, les manifestants sont descendus dans la rue pour réclamer la fin des brutalités policières, dans l'une des manifestations pour la justice raciale les plus médiatisées et les plus organisées de l'histoire des États-Unis. Les réseaux sociaux et la technologie vidéo ont été les catalyseurs des manifestations de BLM, mais les services de police ont utilisé ces mêmes technologies pour créer de nouvelles possibilités dangereuses de surveillance. Allie Funk, analyste principal de recherche pour Technologie et Démocratie, a expliqué comment les services de police ont utilisé les réseaux sociaux pour surveiller les manifestants et les organisateurs de Black Lives Matter. À Cookville, dans le Tennessee, des agents du FBI de la Joint Terrorism Task Force (JTTF) ont utilisé les médias sociaux pour identifier plusieurs organisateurs de manifestations BLM. Les agents fédéraux se sont présentés à l'improviste au domicile et sur le lieu de travail des organisateurs pour les interroger sur leurs publications Facebook et leurs projets de manifestation.

L'utilisation de réseaux sociaux pour identifier suspects et criminels s'inscrit dans une tendance de surveillance par le big data, et précisément, dans une tendance d'analyse prédictive par la police. Le Brennan Center for Justice de l'université de droit de New York explique que la police prédictive consiste à "utiliser des algorithmes pour analyser des quantités massives d'informations, prédire, et aider à prévenir de futurs crimes". À la suite des attentats du 11 septembre 2001, le partage de l'information est devenu une priorité ; la loi sur la sécurité intérieure de 2002 a donc permis d'allouer des fonds fédéraux au développement de mesures de police prédictive (niveau local et étatique), afin de déjouer toute nouvelle attaque. Aussi, des centres de surveillance, appelés "centres de fusion", ont été créés dans le but de promouvoir une communication ouverte entre les différents agents de la société ; en leur sein, on retrouve des données publiques comme privées, des dossiers de police, des photos ou encore des vidéos provenant des forces de l'ordre ou de particuliers. En ce sens, la surveillance au nom de la prévention de la criminalité n'a fait que s'intensifier avec le développement de l'analyse prédictive, d'autant plus que les forces de l'ordre ont commencé à s'associer au secteur privé pour collecter, stocker et analyser les données. En réalité, au-delà d'une volonté de performance accrue, la police adhère graduellement à ces pratiques privées pour s'éviter de la "paperasserie", étant donné que les rapports de données recueillies par le secteur privé sont soumis à moins de contrôles juridiques. [1]

Les services répressifs des États-Unis emploient une pléthore de programmes privés et d'outils algorithmiques dans l'espoir d'utiliser la police prédictive pour arrêter la criminalité avant qu'elle ne soit commise. Les outils de surveillance algorithmique standard utilisés pour recueillir des données, tant à titre privé que par les services répressifs eux-mêmes, sont les lecteurs automatiques de plaques d'immatriculation (LAPI), les logiciels de surveillance des médias sociaux, la technologie de reconnaissance faciale et l'analyse des réseaux sociaux. Dans tous ces outils, les informations sont prélevées à la source et utilisées pour cartographier les relations sociales, identifier les suspects et prédire les comportements futurs[2]. [Le programme NOLA for Life de la ville de la Nouvelle-Orléans, qui a utilisé des programmes prédictifs comme Palantir, une société privée d'analyse de données qui collecte, stocke et analyse des données, pour aborder la criminalité sous l'angle de la santé publique, est un exemple de réussite. La ville a tout cartographié, des victimes probables de la criminalité aux auteurs à risque en passant par les lieux de rencontre des gangs, et est intervenue avec 29 programmes de services sociaux différents. La Nouvelle-Orléans a connu une réduction de 55 % des meurtres commis par des groupes et des gangs entre 2011 et 2014, et l'utilisation de données pour informer les stratégies de réduction de la criminalité a été un facteur crucial[3]. [Malgré cela, le public n'a pas été informé de l'utilisation des technologies Palantir dans la ville et, souvent, ces technologies sont utilisées pour orienter les mesures punitives plutôt que dans le cadre d'une stratégie holistique. L'utilisation de programmes de surveillance privés offre également d'immenses possibilités d'abus et de problèmes de protection de la vie privée. En outre, les critiques mettent en garde contre le fait que l'utilisation de la police prédictive peut en fait renforcer la discrimination raciale dans le système de justice pénale.

En réponse à ces accusations, les partisans de la police prédictive soulignent la nature impartiale des données, affirmant que, puisque les "chiffres sont neutres", les préjugés raciaux ne peuvent que s'estomper. À première vue, cela semble vrai : la criminalité n'est localisée que de manière géographique, puis, parmi des personnes identifiées pour leurs actes délinquants. Par exemple, à Boston, 70 % des fusillades sur une période de trois jours étaient concentrées dans 5 % de la ville, et les données montrent que les auteurs de crimes violents étaient le plus souvent des hommes jeunes au casier judiciaire vierge. [4] En gardant cela à l'esprit, la saisie d'informations concernant uniquement le lieu et les auteurs des crimes passés devrait constituer une évaluation pratique et objective pour prédire les crimes futurs. Pour autant, il convient de rappeler que les structures algorithmiques s'ancrent dans des hiérarchies de pouvoir existantes et dans les structures institutionnelles qui en découlent -et de là provient la dimension davantage subjective des systèmes de surveillance.

Sarah Brayne, dans son livre Predict and Surveil : Data Discretion, and the Future of Policing, explique l'aspect social des données en écrivant que "les bases de données sont alimentées par des informations collectées à la suite de décisions humaines, analysées par des algorithmes créés par des programmeurs humains, et mises en œuvre et déployées dans la rue par des agents humains qui suivent les ordres de leurs supérieurs et leur propre intuition" (Brayne 135). Les données ne sont pas créées dans le vide : elles sont façonnées par les personnes qui en déterminent la collecte, le déploiement et la gouvernance. Cela dit, les structures algorithmiques utilisées par la police sont entachées de préjugés humains. Le programme Operation LASER du LAPD est un exemple d'outil de police prédictive qui a renforcé la discrimination raciale existante dans le système de justice pénale tout en étant masqué par l'apparence impartiale des données. Le programme a été mis en place en 2011 pour cibler les individus les plus susceptibles de commettre un crime, en fonction de leurs antécédents criminels, de leurs fiches d'entretien sur le terrain, de leurs contraventions, de leurs patrouilles quotidiennes et de leurs interactions "de qualité" avec la police, etc. Chaque individu se voit attribuer un score de "risque" et est potentiellement placé sur une liste de délinquants chroniques, qui est envoyée aux services de police. Les détracteurs du programme se sont inquiétés du risque de boucles de rétroaction : si un individu interagit avec la police, son score augmentera, ce qui justifiera une plus grande interaction avec cet individu, et le cycle se répétera. En outre, bien que les données semblent impartiales, tous les chiffres entrés dans le programme proviennent d'enregistrements antérieurs, ce qui signifie que des préjugés antérieurs de la police pourraient encore se glisser dans les ensembles de données. Suite aux pressions exercées par la coalition STOP LAPD Spying, l'inspecteur général du LAPD a réalisé un audit interne du programme LASER, qui a révélé des irrégularités dans le système des "délinquants chroniques". L'audit a révélé que près de la moitié des personnes désignées comme "délinquants chroniques" n'avaient fait l'objet d'aucune arrestation ou d'une seule et que les interactions avec les "délinquants chroniques" manquaient de cohérence. En 2019, le LAPD a mis fin au programme LASER à la lumière des informations de l'audit.

Ceci illustre à quel point les outils prédictifs exacerbent les inégalités en utilisant des données provenant de lieux traditionnellement surcontrôlés, surpolicés. De multiples échantillons biaisés sont intégrés dans les algorithmes et perpétuent de fait des stigmatisations raciales, alors même que ces outils visent à purifier les services de police de tout préjugé ethno-racial. C'est pourquoi il est nécessaire que ces problèmes soient résolus par des données, mais aussi par des interventions personnelles, des formations et la restructuration de nos services de police. Le potentiel des données en matière de réduction de la criminalité n'est toutefois pas à remettre en cause -lorsqu'elles sont collectées de manière égale. En effet, dans ce cas, elles permettent d'utiliser efficacement les ressources de la police pour identifier les auteurs de crimes et cartographier les tendances de l'activité criminelle. Alors comment maximiser les avantages des programmes prédictifs tout en minimisant leur penchant discriminatoire ?

Sarah Brayne propose des stratégies complètes pour faire évoluer la manière dont les services de police utilisent les programmes prédictifs. Celles-ci reposent essentiellement sur l'utilisation de données pour "policer la police". Brayne écrit que "Si l'on aborde l'idée de surveillance sous un autre angle, les données peuvent être utilisées pour mettre en lumière les problèmes existants dans les pratiques policières, c'est-à-dire pour surveiller les performances de la police et ses taux de réussite, et même estimer et potentiellement réduire les biais qui déterminent les arrestations qu'elle effectue" (Brayne 143). En d'autres termes, les données peuvent être exploitées tant pour identifier et retracer les erreurs policières et les tendances discriminatoires des agents que pour mesurer le coût de tactiques spécifiques. Cela étant dit, les structures juridiques couvrant l'utilisation des données par la police, et en particulier les données collectées à titre privé, doivent être plus solides (ici, au sens de "fondées") et se plier au principe de transparence. Lorsque cela sera le cas, je crois sincèrement que les données pourront rendre le maintien de l'ordre plus efficace et plus équitable.

En outre, Brayne insiste sur la nécessité pour les services répressifs de ralentir avant de mettre en œuvre des outils d'évaluation algorithmique, et je suis d'accord avec son affirmation selon laquelle "il devrait incomber aux services répressifs de justifier l'utilisation de big data et de nouveaux outils de surveillance avant leur déploiement massif" (Brayne 142). Brayne note que la seule étude du LASER qui a fait l'objet d'un examen par les pairs a été menée par un membre de l'entreprise qui l'a conçu. L'utilisation d'outils d'analyse prédictive de masse devrait être précédée d'une évaluation par des agences indépendantes, de forums communautaires et d'une collaboration entre des agents interdisciplinaires, y compris des avocats et des experts communautaires, ainsi que des policiers et des architectes de programmes. Ceci étant dit, les technologies elles-mêmes ont la responsabilité de déployer des programmes dans l'intérêt public. Une stratégie consiste à ajouter un certain degré d'aléatoire aux programmes prédictifs, en envoyant des agents dans des lieux présentant des niveaux de risque variables afin de réduire les biais dans les ensembles de données. L'outil de police prédictive HunchLab fait cela et plus encore ; la base de données du programme ne comprend que les crimes enregistrés publiquement, laissant de côté les activités criminelles mineures qui sont en corrélation avec la pauvreté et impliquent une plus grande discrétion de la part des agents et une partialité potentielle sur les lieux.

Ainsi ces stratégies contribueront-elles à réduire les biais altérant la véracité des structures algorithmiques. Néanmoins, nous ne pouvons pas réformer le système prédictif actuel sans nous demander en quoi consisterait un maintien de l'ordre optimal ou remarquable. S'agit-il de réduire les taux de criminalité ? D'assurer la sécurité des individus ? En réalité, un maintien de l'ordre efficace va au-delà des limites traditionnelles de l'application de la loi ; il s'agit de s'attaquer aux causes profondes de la criminalité, comme la pauvreté et l'éducation, et de reconnaître quand l'intervention de la police est légitimement nécessaire. Par exemple, réformer le maintien de l'ordre peut signifier restructurer les systèmes d'urgences liés à la santé mentale, en diminuant l'intervention de la police et en favorisant celle de professionnels de la santé. Les programmes prédictifs ont la capacité d'améliorer notre société et de garantir la sécurité de nos communautés. Cependant, pour que ces objectifs soient atteints, les analyses doivent permettre la conception de solutions sociales et la mise en place d'interventions ciblées pour les personnes dites "à risque". En fin de compte, l'engagement communautaire, la transparence et la collaboration entre sociologues, membres de la société civile, avocats et programmeurs, seront essentiels pour transformer la police prédictive en une version optimale pour tous.

Références

[1] Predict and Surveil : Data, Discretion, and the Future of Policing, par Sarah Brayne, Oxford University Press, 2021.

[2] Miles Kenyon, "Algorithmic Policing in Canada Explained", The Citizen Lab, dernière modification le 1er septembre 2020, https://citizenlab.ca/2020/09/algorithmic-policing-in-canada-explained/.

[3] "Whom We Police : Person-Based Predictive Targeting ." The Rise of Big Data Policing : Surveillance, Race, and the Future of Law Enforcement, par Andrew G. Ferguson, New York University Press, 2020, pp. 49-51, 55.

[4] "Sticky Situations". Bleeding out : the Devastating Consequences of Urban Violence--and a Bold New Plan for Peace in the Streets, par Thomas Abt, Basic Books, 2019, pp. 35-46.